Kto i kiedy wynalazł komputer? Na to pytanie niełatwo odpowiedzieć. Zakłada ono bowiem, że nowe odkrycia są dziełem jednego

człowieka – genialnej jednostki, która przy pomocy swoich dzieł zmienia bieg

historii. W rzeczywistości jednak, każdy wielki wynalazca korzysta z dorobku swoich poprzedników. Nawet najwybitniejsi nie mogą się również obejść bez pomocy i wsparcia współczesnych. Nie

umniejsza to oczywiście zasług pojedynczych uczonych. Niemniej jednak, jeśli chce się odmalować bardziej realistyczny obraz odkrycia, trzeba wskazać więcej niż jedną osobę odpowiedzialną za wynalazek, a zamiast daty, opisać cały proces powstawania danej koncepcji czy też urządzenia.

Pierwszym, który

zaprezentował w Europie koncepcję uniwersalnego systemu, który pozwalałby na

przetwarzanie wszelkich pojęć obecnych w języku naturalnym przy pomocy maszyny

opartej na systemie binarnym był Gottfried Wilhelm Leibniz.

Oznacza to, że aby dotrzeć do korzeni współczesnych komputerów trzeba cofnąć

się aż do XVII wieku! Jeśli zaś chcemy sięgnąć do źródeł mechanizacji procesów obliczeniowych, musimy sięgnąć jeszcze głębiej w odmęty historii.

Zanim ludzie zaczęli myśleć o maszynach przetwarzających

wszelkie informacje (lub wręcz o myślących maszynach) stosowali urządzenia i

techniki, które pomagały im w dokonywaniu prostych obliczeń. Pierwsze "liczydła" to prawdopodobnie zaledwie linie kreślone na piasku według przemyślanego

systemu. Nie były zatem trwałymi urządzeniami, lecz koncepcją, która później

pozwoliła na zbudowanie czegoś bardziej namacalnego. Takie ręczne maszyny mające swoją materialną formę nazywano dawniej abakusami. Były one znane już starożytnym Grekom, Rzymianom a także

Chińczykom (i zapewne jeszcze kilku innym nacjom). Z biegiem czasu abakusy ulepszano,

ale dopiero XVII wiek przyniósł bardziej znaczący postęp w tej dziedzinie.

Wtedy też w Europie upowszechniała się powoli tendencja do myślenia o

myśleniu jako procesie mechanicznym. W 1655 roku Thomas Hobbes wyraził

myśl per ratiocinationem autem intelligo

computationen – "przez rozumowanie rozumiem rachowanie". Ujmował

on myślenie jako takie jako proces obliczeniowy:

"Rachować zaś to w istocie tyleż, co tworzyć sumę z wielu rzeczy do siebie dodanych albo wyznaczać resztę po odjęciu jednej rzeczy od drugiej. Rozumować więc, to to samo, co dodawać i odejmować; zgodzę się też, jeśli ktoś do tego doda mnożenie i dzielenie, jako że mnożenie jest tym samym, co dodawanie rzeczy równych, dzielenie zaś tym samym, co odejmowanie wielkości równych, ile razy to jest tylko możliwe. Rozumowanie sprowadza się więc do dwóch czynności umysłu, do dodawania i odejmowania."

Poglądy Hobbesa były często krytykowane, a on sam w obawie

przed konsekwencjami spalił część swoich rękopisów. Fragmenty jego dzieł świadczą jednak o dokonującej się w XVII wieku zmianie w sposobach ujmowania procesów myślenia. Była ona prawdopodobnie istotnym czynnikiem, dzięki któremu dokonał się rozwój maszyn liczących. Wskazywałby na to chociażby fakt, że wspomniana zmiana zbiegała się w czasie z powstaniem nowych urządzeń służących do wykonywania obliczeń.

W 1642 roku Blaise Pascal przedstawił swoją maszynę

sumującą. Ponad 30 lat później swój wynalazek zaprezentował również Leibniz. 22

stycznia 1673 roku pokazał światu na forum Royal Society arytmometr – ręczną

maszynę liczącą w systemie dziesiętnym. Równocześnie pracował nad calculus rationcinator czyli rachunkiem

logicznym mającym być pierwszym krokiem do arytmetyzacji wszelkich pojęć.

Gottfryd Leibniz jest uważany przez niektórych za jeden z najgenialniejszych

umysłów nowożytnej Europy. Z pewnością nie można mu odmówić nie tylko

inteligencji, lecz również pracowitości. Zainspirowany systemem dwójkowym,

którego wynalezienie przypisywał Chińczykom, już w 1679 przedstawił koncepcję

machiny cyfrowej (binarnej), w której gałki reprezentujące liczby wędrowały

niczym kule bilardowe w systemie sterowanym przez coś, co można uznać za

prymitywną wersję karty perforowanej. Przewidział, że te same operacje da się

wykonać nawet bez kul. Jest to w zasadzie pierwszy konceptualny opis zasady

działania komputera. Współcześnie, kule zostały zastąpione przez ładunki

elektryczne. Generalny zamysł pozostał jednak z grubsza niezmieniony.

Niektórzy być może chcieliby wiedzieć w osobie Leibniza

prekursora sztucznej inteligencji. Pogląd ten jest jednak trudny do

utrzymywania. Gottfried Leibniz uważał, że "duszy" nie da się

zredukować do mechanizmu. Na poparcie swojej tezy zaprezentował eksperyment

myślowy nazywany od jego nazwiska "młynem Leibniza". Rozumowanie we

wspomnianym eksperymencie było dość proste: wyobraźmy sobie, że umysł dałoby

się powiększyć do rozmiarów młyna, do którego mógłby wejść człowiek. Filozof

twierdził, że obserwator znajdujący się wewnątrz mógłby zobaczyć koła zębate,

dźwignie, przekładnie i tłoki, ale nigdzie nie mógłby dostrzec niczego, co

można by nazwać "myśleniem" lub "duszą". Nie może być ona

zatem mechaniczna. Wniosek ten nie wynika jednak z przesłanek, a cały

eksperyment jest zakamuflowaną tautologią. Leibniz musiał założyć a priori, że mechanizm nie może być

"duszą", żeby stwierdzić, że obserwując maszynę nie da się jej zobaczyć.

Eksperyment zaproponowany przez filozofa pokazuje, że mimo niewątpliwych zasług

dla rozwoju komputerów, nie wierzył on w mechaniczność "duszy" i "myślenia".

Wracając do głównego wątku: wizja budowy cyfrowej maszyny analitycznej Leibniza nie mogła zostać urzeczywistniona bez systemu

pozwalającego na wyrażanie rozmaitych pojęć w sposób mechaniczny. Sam Leibniz nigdy go

nie opracował. Problemem zajął się ok. 150 lat później Charles Babbage. Jak

utrzymywał, od 1812 lub 1813 roku zaczął myśleć o przeliczaniu maszynowym.

Opracował system nazywany "notacją mechaniczną" i w 1834 rozpoczął

pracę nad maszyną, której możliwości miały znacznie przekraczać możliwości

arytmometrów. Maszyna miała móc zmieniać rejestry swojej pamięci wewnętrznej.

Była też wyposażona w oddzielony od pamięci podzespół stanowiący centralną

jednostkę przetwarzającą informacje. Sposób jej działania opierał się na

wykorzystaniu kart perforowanych, znanych i stosowanych we włókiennictwie w

maszynach Jacquardowskich. Pomysł Babbage'a uznaje się za pierwszą

konceptualizację, a nawet za pierwszy poprawny projekt programowalnego

komputera. Struktura urządzenia do złudzenia przypomina współczesne komputery z

dyskiem twardym, procesorem (CPU – central processing unit) i mechanizmem wejścia (input device). Wynalazca przypisywał maszynie, którą chciał

zbudować niezwykłą rolę. Uważał, że będzie można skutecznie odgadnąć boski

zamysł poprzez obliczanie jego dzieł.

Babbage pracował nad maszyną analityczną do końca swoich dni dożywając wieku ponad 80 lat. W pracach pomagała mu Ada Lovelace – córka

Lorda Byrona. Osiągnął jednak zaledwie część zaplanowanych rezultatów. Jego

urządzenia były co prawda w stanie wykonywać nieco bardziej zaawansowane

obliczenia, ale nie ma większych wątpliwości co do tego, że wynalazcy chodziło

o coś więcej. Mimo wielkich ambicji wynalazcy, nie należy rozpatrywać pracy Babbage'a

jako próby mechanicyzacji procesów "myślenia", lecz jedynie samej arytmetyki

(choć wiemy, że wynalazca wiązał z nią wielkie nadzieje). Matematyczne podstawy

analizy logicznej, niezbędne do przełożenia operacji wykraczających poza arytmetykę (takich jakie wykonują współczesne komputery), opracował George Boole.

W 1847 roku wydał swoją pierwszą książkę na ten temat

Możliwości maszyny Charlesa Babbage'a musiały być

ograniczone, lecz nawet jeśli był to tylko projekt będący realizacją pomysłu o

mechanicyzacji arytmetyki (a nie myślenia jako takiego), jego urzeczywistnienie

musiałoby być niezwykłym osiągnięciem wyprzedzającym swoje czasy. Czy

stworzenie komputera w XIX wieku było realnym scenariuszem? W ramach

obchodów 200-lecia urodzin Babbage'a, zespół naukowców pod kierownictwem Dorona

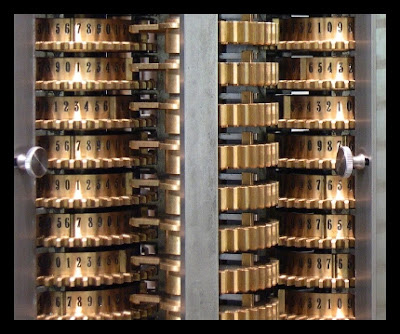

Swade'a postanowił to sprawdzić. Swade podjął się próby rekonstrukcji projektu

Babbage'a na podstawie jego rysunków z 1847 roku, przedstawiających projekt

noszący nazwę "Maszyna różnicowa 2". Wykonano ponad 4 tys. elementów,

które złożyły się na 3-tonową maszynę. Swade napisał w swoim artykule, w którym

zdawał sprawę z przebiegu prac, że urządzenie: "bezbłędnie wykonało swoje

pierwsze duże obliczenie i potwierdziło, że źródłem niepowodzeń Babbage'a były

kwestie praktyczne, a nie błędne założenia projektowe".

Czy jest możliwe, że gdyby Charlesowi Babbage'owi udało się

zgromadzić większe fundusze, pierwszy komputer do generalnego zastosowania

powstałby o wiele wcześniej? Wiele na to wskazuje. Choć Babbage nie działał w

próżni i wiele zawdzięczał swoim poprzednikom, rzeczywiście mógł być

człowiekiem, który nieomal w pojedynkę zmieniłby bieg historii.

Źródła:

Daniel

Dennett, Słodkie sny. Filozoficzne przeszkody na drodze do nauki o świadomości,

Warszawa 2007, ss. 39-40.

Doron D.

Swade, Redeeming Charles Babbage's

Mechanical Computer, "Scientific American" 1993 February, Vol.

268, Issue 2, pp. 83-91.

Eugene Eric

Kim & Betty Alexandra Toole, Ada and

the First Computer, "Scientific American" 1999 May, Vol. 5 Issue

280, pp. 76-81.[http://www.cs.virginia.edu/~robins/Ada_and_the_First_Computer.pdf]

[07.07.2015]

George B. Dyson, Darwin

wśród maszyn. Rzecz o ewolucji inteligencji, Warszawa 2005.

Jörn Lütjens, The abacus – one of

the oldest calculation devices [http://www.hh.schule.de/metalltechnik-didaktik/museum/abakus/luetjens-abacus.pdf]

[07.07.2015].

[https://upload.wikimedia.org/wikipedia/commons/6/6a/LondonScienceMuseumsReplicaDifferenceEngine.jpg]

[07.07.2015]

Brak komentarzy:

Prześlij komentarz